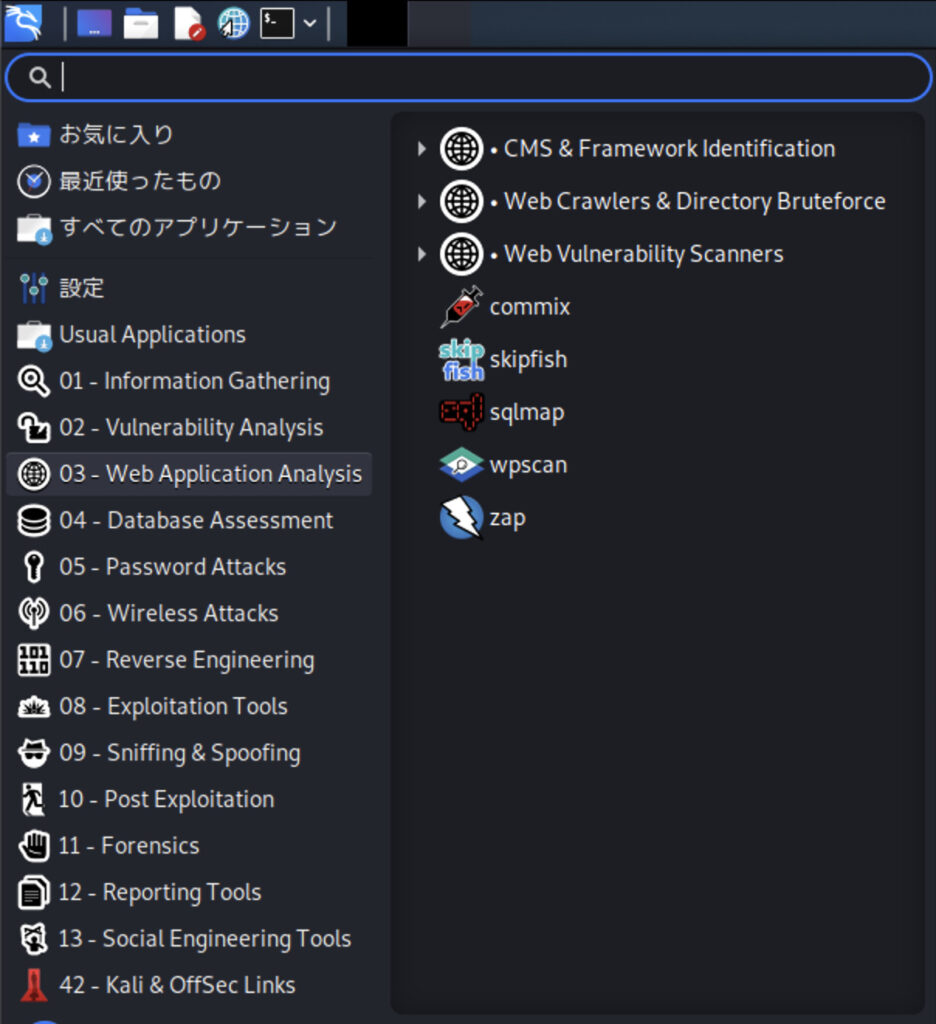

03-Web Applications Analysis、Webアプリケーション診断。

これも知らない分野。

commixは、コマンドインジェクション攻撃対策に関したエクスプロイトツール。これに関するダミーサイトが無いので、結果が出てこない。commix –url ○○○ といった使い方になるようだ。

さて、Googleが開発したというWebアプリの脆弱性を診断するすごいらしいツール、skipfish。

これも知らない。

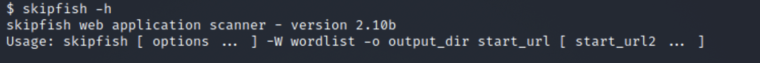

ただ、これはちょっと面白いかもしれない。まずはコマンドから。

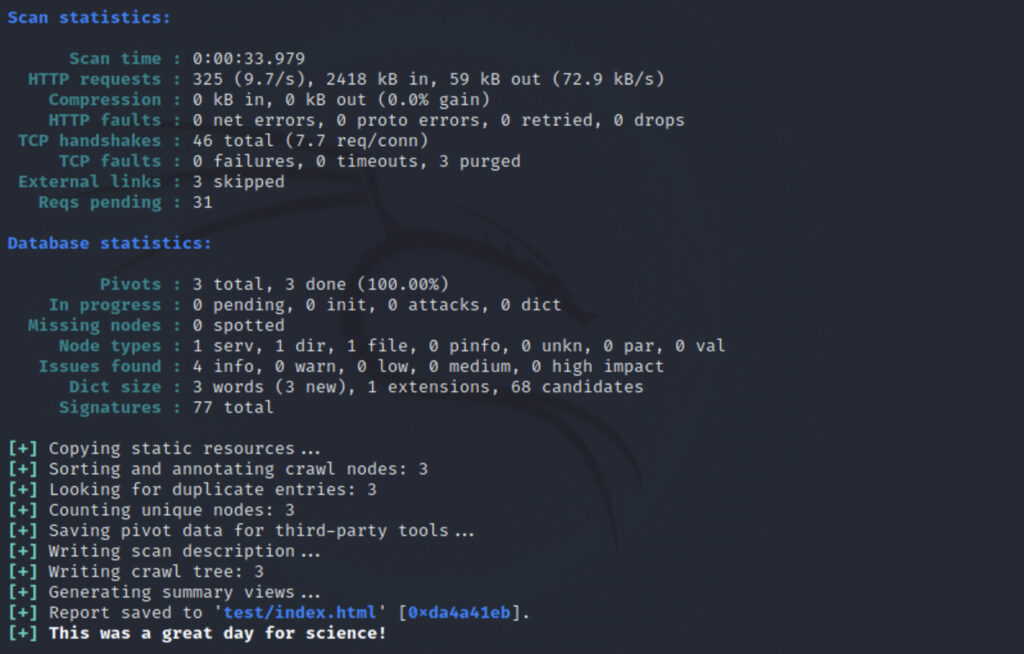

-o をつけることで、レポート出力ができるようだ。

| $ skipfish -h skipfish web application scanner – version 2.10b Usage: skipfish [ options … ] -W wordlist -o output_dir start_url [ start_url2 … ] Authentication and access options: -A user:pass – use specified HTTP authentication credentials Crawl scope options: -d max_depth – maximum crawl tree depth (16) Reporting options: -o dir – write output to specified directory (required) Dictionary management options: -W wordlist – use a specified read-write wordlist (required) -z sigfile – load signatures from this file Performance settings: -g max_conn – max simultaneous TCP connections, global (40) Other settings: -l max_req – max requests per second (0.000000) Send comments and complaints to <heinenn@google.com>. |

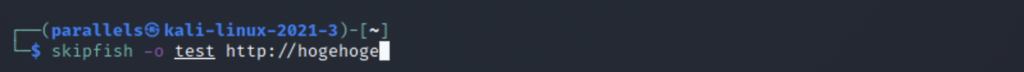

まず、ターゲットに対し、testフォルダにレポート出力するコマンド。

skipfish -o test ○○○

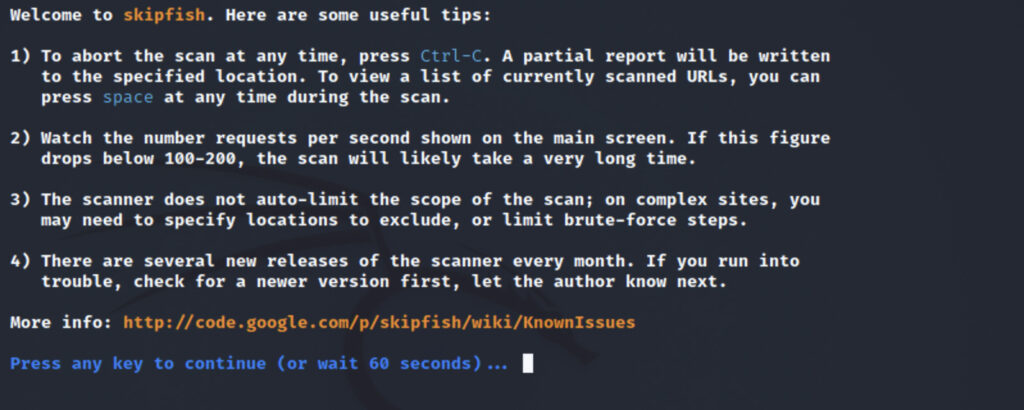

選択肢。ここではそのままEnterを押してみた。

ば〜と表示された。

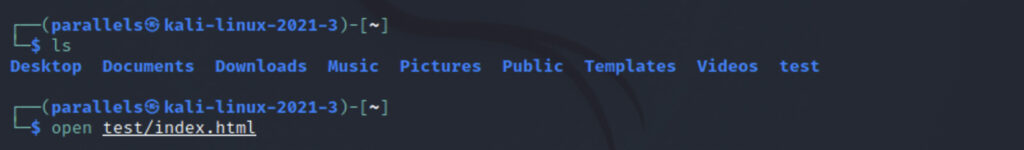

スキャン結果は、testフォルダにある。

htmlファイルなので、開いてみましょう。

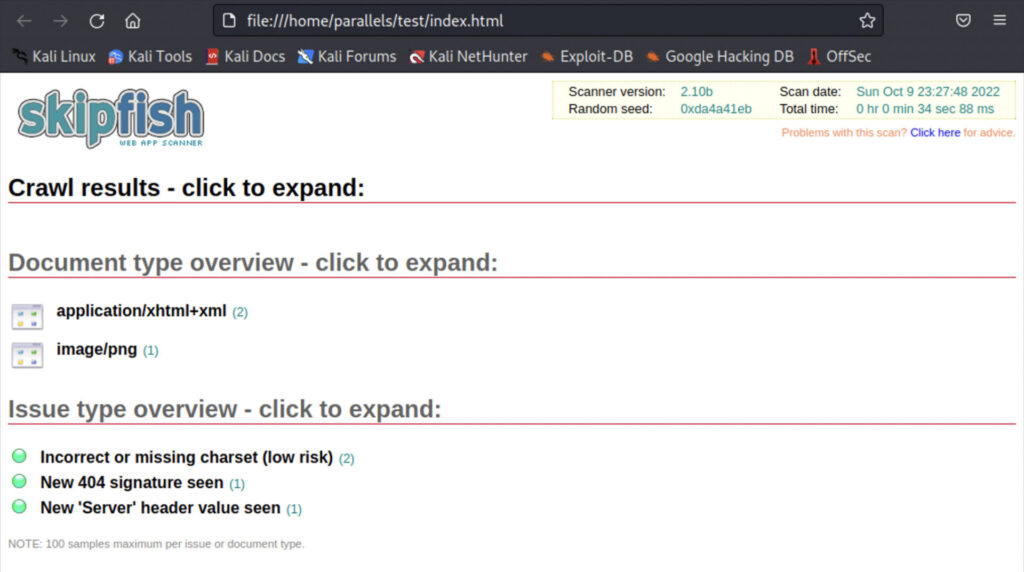

開いた。

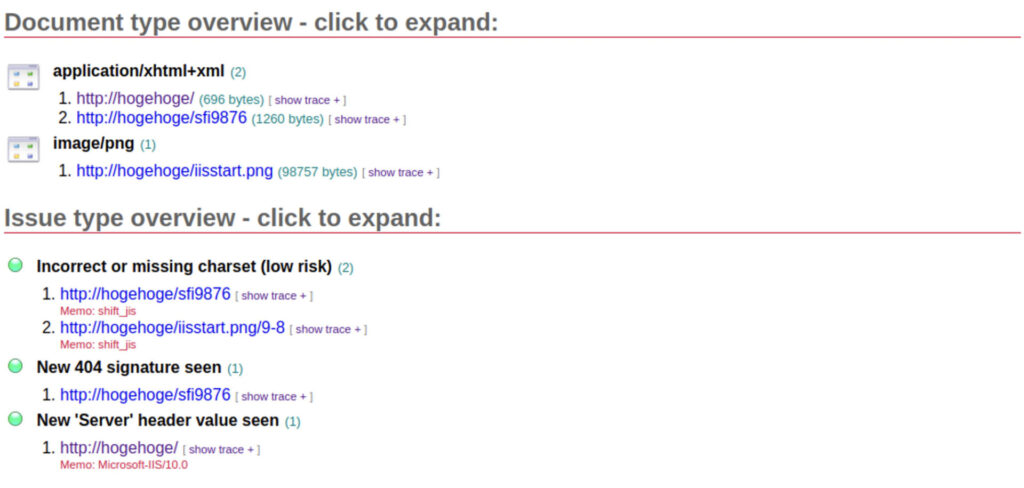

展開してみるよ。

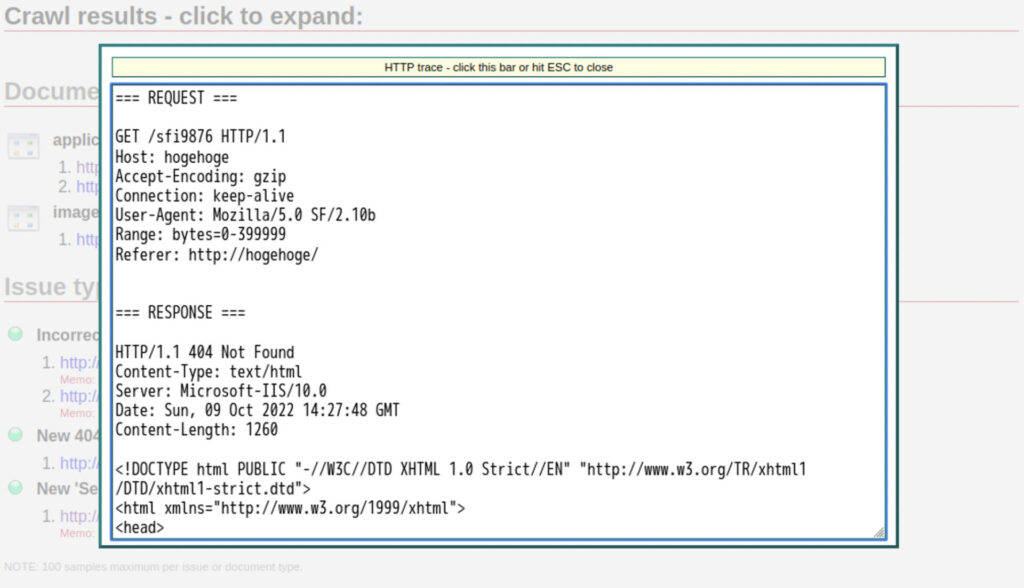

show traceをクリックしてみた。

こういった診断するためには、欠陥のあるwebサイトを作っていた方が良いですね…(汗)

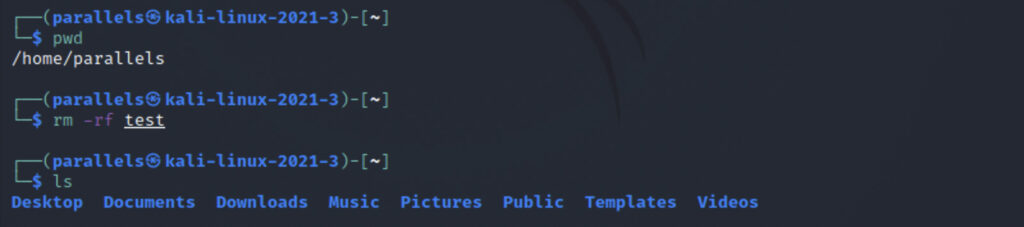

今回利用したレポートフォルダ、「test」。邪魔なので、禁断な方法で削除しておきましょう。

ファイルがあっても構わない、フォルダ(ディレクトリ)丸ごと削除!

怖すぎる。rm -rh フォルダ

testフォルダ消えました。

skipfishを覚えていると、ちょっとセキュリティ意識高い系になりそうだ。

wpscan、これは、WordPress向けのセキュリティスキャンのようだ。

wpscan –url https://〜 といった感じかな。

他人のURLをスキャンしたら、不正アクセス禁止法に抵触する恐れがあるので注意!

zap、これは別のページにてアクションしてみましょう。

2 thoughts on “Kali Linuxで遊ぶ〜Web Applications Analysis〜skipfish”

Comments are closed.